L’intelligence artificielle est mystérieuse : on lui parle et elle semble comprendre ce qu’on lui dit. La preuve qu’elle comprend c’est qu’elle répond par un texte ou une parole qui a du sens, et parfois plus de sens que ce que pourrait articuler un humain ordinaire. Comment est-ce possible?

Le succès des modèles de langue

Certes, les recherches sur l’intelligence artificielle datent du milieu du 20e siècle et, même si le grand public ne peut les manipuler directement que depuis 3 ans, les modèles statistiques ou neuro-mimétiques étaient déjà présents “sous le capot” d’une foule d’applications depuis les années 2010. Mais le type d’application grand public que tout le monde appelle maintenant “l’IA” n’est apparu qu’en 2022. Il faut d’abord prendre la mesure du phénomène sur un plan quantitatif. À la fin de 2025, il y avait déjà 700 millions d’utilisateurs hebdomadaires de ChatGPT et 150 millions d’utilisateurs actifs quotidiens pour l’IA générative en général. On estime que 50% des travailleurs américains utilisent des modèles de langue (ChatGPT, Claude, Perpexity, Gemini, etc.), d’ailleurs sans grande augmentation de leur productivité, sauf pour les tâches de programmation et de bureaucratie interne. Sur le plan des mœurs, l’IA s’est tellement imposée dans le paysage numérique que beaucoup de jeunes gens ont l’impression qu’elle a toujours existé. Les étudiants s’en servent pour faire leurs devoirs. Des millions de personnes ont développé une addiction au dialogue avec une machine désormais amie, confidente ou psychothérapeute. Interagir avec un modèle de langue augmente votre estime de soi!

L’interdépendance des problèmes

Tout ceci pose des problèmes éthico-politiques, géopolitiques et civilisationnels. Il est d’ailleurs possible que, dans les années à venir, de nouvelles avancées scientifiques et techniques rendent ces problèmes encore plus aigus. La puissance de mémoire et de calcul qui supporte l’IA se partage aujourd’hui entre les deux oligarchies numériques américaine et chinoise qui rivalisent d’investissements. Cette concentration économique et géopolitique soulève à juste titre l’inquiétude. Les “biais”, les mauvais usages de toutes sortes et les délires probabilistes des machines poussent à la construction de garde-fous éthiques. C’est bien. Il faut néanmoins rappeler que l’éthique ne se limite pas à apaiser les craintes ou à prévenir les nuisances mais qu’elle invite aussi à penser les bons usages et les directions de développement favorables. Avec l’IA, les questions industrielles, éthiques et cognitives sont étroitement codépendantes. C’est pourquoi il est nécessaire d’élucider l’efficace cognitive de cette technique si l’on veut comprendra pleinement ses enjeux industriels, éthico-politiques et civilisationnels.

La question

Comment se fait-il que des algorithmes statistiques, qui calculent la probabilité du mot suivant, puissent générer des textes pertinents et des dialogues engageants ? À mon sens, la solution de cette énigme se trouve dans une compréhension de ce qu’est l’intelligence humaine. Car ce sont des humains qui produisent les milliards de textes qui servent de données d’entraînement. Ce sont encore des humains qui construisent les centres de calcul, étendent les réseaux et conçoivent les algorithmes. Ce sont toujours des humains qui, par leur lecture, projettent un sens sur les textes aveuglément générés par des machines privées de conscience. Mais puisque le secret de l’IA se trouve selon moi dans l’intelligence humaine, je manquerais à ma tâche si je n’expliquais pas en quoi elle consiste.

Qu’est-ce que l’intelligence humaine ?

L’intelligence humaine est d’abord animale, c’est-à-dire qu’elle est ordonnée à la locomotion qui distingue les bêtes des plantes dépourvues de neurones. Le système nerveux organise une boucle entre la sensibilité et la motricité. Cette interface entre la sensation et le mouvement se complexifie au fur et à mesure de l’évolution, jusqu’à l’apparition du cerveau chez les animaux les plus intelligents. Ces derniers deviennent capables de cartographier leur territoire, de retenir des événements passés (ils ont une mémoire) et de simuler des événements futurs (ils ont une imagination). Le fonctionnement du cerveau produit l’expérience consciente, avec ses plaisirs et ses peines, ses répulsions et ses attractions. De là découle toute la gamme des émotions qui colorent les perceptions et induisent les actions. Assignée au mouvement, l’intelligence animale organise son expérience dans l’espace et le temps. Elle vise des buts et se réfère à des objets du monde environnant. A-t-elle affaire à une proie, à un prédateur, à un partenaire sexuel ? De la catégorisation suit le type d’interaction. Il ne fait aucun doute que l’intelligence animale conceptualise. Enfin, l’animal échange une foule de signes avec la faune et la flore de son milieu de vie et communique intensément avec les membres de son espèce.

[On trouvera un développement sur la complexité de l’expérience animale dans ma récente conférence]

L’IA ne possède aucun des caractères de l’intelligence animale : ni la conscience, ni le sens de l’espace et du temps, ni l’intentionalité de l’expérience (la finalité et la référence à des objets), ni l’aptitude à conceptualiser, ni les émotions, ni la communication. Or l’intelligence humaine comprend l’intelligence animale et possède en plus une capacité symbolique qui s’actualise dans le langage, les institutions sociales complexes et les techniques. Malgré sa singularité dans la nature, n’oublions jamais que la capacité symbolique humaine s’enracine dans une sensibilité animale dont elle ne peut se séparer.

[Pour en savoir plus sur l’ordre symbolique, écouter ma conférence sur ce sujet]

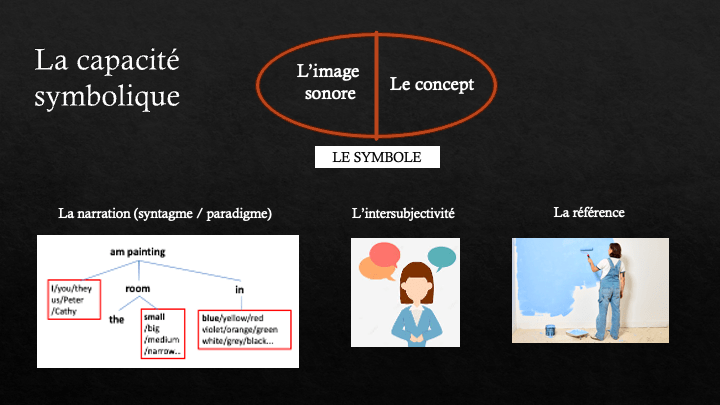

Le langage : entre sensible et intelligible

Je vais examiner plus particulièrement le langage, grâce à qui nous pouvons dialoguer, raconter des histoires, poser des questions, raisonner et spéculer sur l’invisible. Commençons par analyser la composition d’un symbole. Il comprend une partie sensible, une image visuelle ou sonore (le signifiant) et une partie intelligible ou concept (le signifié). On a vu que les animaux avaient des concepts, mais l’Homme seul représente ses concepts par des images, ce qui lui permet de les réfléchir et de les combiner à volonté. Les symboles, et en particulier les symboles linguistiques, ne sont jamais isolés mais font partie de systèmes symboliques qui sont intériorisés par les interlocuteurs. Il faut que la grammaire et le dictionnaire de notre langue commune fasse partie de nos automatismes pour que nous nous comprenions de manière fluide. Les textes appartiennent simultanément à deux mondes qu’ils connectent à leur manière : ils possèdent une adresse spatio-temporelle par leur partie sensible et ils se distribuent en d’invisibles réseaux de concepts par leur partie intelligible.

Que signifie comprendre une phrase? Prenons l’exemple simple qui suit : “Je peins la petite pièce en bleu”. Je fais d’abord correspondre au son de chaque mot son concept. Puis, à partir de la séquence parlée, je construis l’arbre syntaxique de la phrase avec, à la racine, le verbe “peins”, à la feuille-sujet le mot “je”, à la feuille-objet l’expression “la petite pièce” et à la feuille-complément de manière le mot “bleu”. Mais ce n’est pas tout. Pour vraiment comprendre “je”, il me faut savoir que la première personne a été choisie par opposition à la seconde et à la troisième personne. Pour saisir “bleu” je dois savoir que c’est une couleur et qu’elle représente une sélection parmi le paradigme des couleurs (jaune, rouge, vert, violet, etc.). Et ce n’est que par rapport à grand, long ou étroit que “petite” fait sens. Bref, dans une expression symbolique simple telle qu’une courte phrase, chaque mot occupe une place dans un arbre syntaxique et actualise un choix dans un groupe de substitutions possibles.

Les phrases sont généralement proférées par des sujets en situation d’interlocution. Mes automatismes symboliques ne se contentent pas de reconstituer le sens linguistique d’une phrase à partir d’une séquence de sons, ils projettent aussi une subjectivité, une intériorité humaine, à la source de la phrase. La parole s’élève dans le va-et-vient d’un dialogue. Je situe cette phrase dans l’histoire et l’avenir possible d’une relation, au sein d’un contexte pratique particulier. D’autre part, une expression symbolique fait le plus souvent référence à une objectivité, à une réalité extra-linguistique, voir extra-sociale. Enfin, elle éveille en moi une foule de résonnances affectives plus ou moins conscientes.

En somme, l’image symbolique, qui est sensible et matérielle, va déclancher dans l’esprit humain la production et le tissage cohérent d’un sens intelligible à partir d’une multitude de fils sémantiques : un sens conceptuel ; un sens narratif par la reconstitution d’arbres syntaxiques et de groupes de substitution paradigmatiques ; un sens intersubjectif et social ; un sens référentiel objectif ; un sens affectif et mémoriel. C’est dire que, une fois recueilli par l’intelligence humaine, un texte matériel devient solidaire de toute une complexité immatérielle, complexité qui n’est nullement aléatoire mais au contraire fortement structurée par les langues, les rituels de dialogue et les règles sociales, la logique des émotions, la cohérence contextuelle inhérente aux corpus et aux mondes de référence. La capacité des modèles de langue à « raisonner » et à répondre aux requêtes de manière pertinente est un effet de corpus, en rapport avec la priorité accordée aux données d’entraînement dialogiques et à celles qui adoptent un style démonstratif. Les énormes données d’apprentissage permettent une capture statistique des normes de discours.

Or c’est précisément cette solidarité entre la partie matérielle des textes – désormais numérisés – et leur partie immatérielle que va capter l’intelligence artificielle. N’oublions pas que seul le signifiant (les séquences de 0 et de 1) existe pour les machines. Pour elles, il n’y a ni concepts, ni récits, ni sujets, ni mondes de référence réels ou fictifs, ni émotions, ni résonnances liées à une mémoire personnelle et encore moins un quelconque enracinement dans une expérience sensible de type animal. Ce n’est que grâce à la quantité gigantesque des données d’entraînement et à l’énorme puissance des centres de calcul contemporains que les modèles statistiques parviennent à réifier la relation entre la forme sensible des textes et les multiples couches de sens que détecte spontanément un lecteur humain.

Données d’entraînement et puissance de calcul

L’IA contemporaine repose sur quatre piliers :

1) les données d’entraînement,

2) la puissance de calcul,

3) les algorithmes de traitement statistique qui simulent grossièrement des réseaux neuronaux (deep learning),

4) les résultats de divers travaux “manuels” tels que les bases de données spécialisées, les graphes de connaissances qui catégorisent et structurent les données, les retours d’évaluation in vivo qui permettent des réglages fins.

Examinons plus en détail les deux premiers piliers. Les archives et mémoires analogiques ont pour la plupart été numérisées. La plus grande partie de la mémoire collective est maintenant directement produite sous forme numérique. 68% de la population mondiale était connectée à Internet en 2025 (seuls 2% de la population mondiale l’était en 2000). La foule présente en ligne produit et consomme une quantité phénoménale d’information. Or le plus petit geste dans une application, le moindre regard vers un écran alimentent les données d’entraînement des IA. Les algorithmes sont capables de prendre en compte plusieurs pages dans leur “attention” statistique. Les vastes corpus d’entraînement fournissent des contextes élargis qui permettent de raffiner le sens des mots et des expressions au-delà de ce qu’un dictionnaire pourrait proposer. On comprend donc que les modèles de langue puissent calculer des corrélations entre signifiants matériels qui impliquent – pour un lecteur humain – les significations immatérielles correspondantes. Mais il faut mobiliser pour cela une puissance de calcul inouïe. Alphabet, Amazon, Apple, Meta, Microsoft, NVIDIA et Tesla ont dépensé plus de 100 milliards de dollars dans la construction de centres de données entre Aout et Octobre 2025. Des centrales nucléaires dédiées vont bientôt alimenter les centres de données en électricité. La puissance de calcul agrégée du monde est plusieurs millions de fois supérieure à ce qu’elle était au début du 21e siècle.

Conclusion

Récapitulons les différents aspects de l’intelligence et du travail humain qui permettent aux IA de nous donner l’impression qu’elles comprennent le sens des textes. Les industriels fabriquent les installations qui supportent la puissance de calcul. Les informaticiens conçoivent et implémentent les logiciels qui effectuent les traitements statistiques. Des ontologistes (dont je suis) créent des règles, des systèmes d’étiquettes sémantiques, des graphes de connaissance et des bases de données spécialisées qui corrigent la dimension purement probabiliste des sytèmes d’IA. Des armées d’employés trient, collectent et préparent les données, puis supervisent l’entraînements des modèles. Des testeurs raffinent les réponses données par les machines, détectent leurs biais et tentent de les réduire. Je n’ai pas encore énuméré les deux facteurs qui expliquent le mieux l’intelligence des modèles de langue. Car c’est l’intelligence collective humaine qui produit les données d’entraînement, données qui enveloppent la solidarité entre les textes et leur sens. Enfin, à partir des images signifiantes générées sur un mode probabiliste par des modèles mécaniques et inconscients, c’est bel et bien l’esprit des utilisateurs vivants qui évoque des concepts, des récits, des intentions référentielles, la cohérence d’un monde réel ou fictif, une intersubjectivité dialogante, des intuitions spatio-temporelles et enfin des émotions, toutes dimensions du sens qui sont le propre de l’intelligence humaine.

En fin de compte, l’IA fonctionne comme une interface mécanique entre l’intelligence collective qui produit les données d’entraînement et les intelligences individuelles qui interrogent les modèles, lisent leurs réponses et les utilisent. Cette interface robotique entre les intelligences personnelles vivantes et l’intelligence collective accumulée augmente aussi bien – et de manière synergique – les unes que l’autre. Tel est le secret de l’intelligence artificielle, bien caché sous la fiction d’une IA autonome, qui “dépasse” l’intelligence humaine, alors qu’elle l’exprime et l’augmente. Dans ses effets concrets, ce nouveau système d’alimentation réciproque de l’intelligence individuelle et de l’intelligence collective peut contribuer à l’abrutissement des masses paresseuses et à l’extension de la banalité, comme il peut démultiplier les capacités créatives des savants et des penseurs originaux. Entre les deux, toutes les nuances de gris sont possibles. Dans l’éventail des possibilités entre ces deux extrêmes se trouve sans doute l’ultime choix éthique qui, bien qu’il concerne chacun d’entre nous, se pose de manière encore plus aiguë pour les éducateurs qui doivent enseigner l’art de lire, d’écrire et de penser. [Voir mon entrée de blog consacrée à ce sujet].