Le Livre Blanc d’IEML, le métalangage de l’économie de l’information. 2019.

RESUMÉ. IEML est une langue à la sémantique calculable inventée par Pierre Lévy. Le “Livre blanc” (version Beta et non finie) explique les grands principes, la grammaire et les premières applications d’IEML. (une centaine de pages)

Etre et Mémoire dans la revue Sens Public 2019

RÉSUMÉ Le premier enjeu de cet article est de replacer l’objet des sciences humaines (la culture et la signification symbolique) dans la continuité des objets des sciences de la nature. Je fais l’hypothèse que le sens n’apparaît pas brusquement avec l’humanité mais que différentes couches de codage et de mémoire (quantique, atomique, génétique, nerveuse et symbolique) s’empilent et se complexifient progressivement, la strate symbolique n’étant que la dernière en date des « machines d’écriture ». Le second enjeu du texte est de définir la spécificité et l’unité de la couche symbolique, et donc le champ des sciences humaines. Par opposition à une certaine tradition logocentrique, je montre que le symbolisme – s’il comprend évidemment le langage – englobe aussi des sémiotiques (comme la cuisine ou la musique) où la coupure signifiant/signifié n’est pas aussi pertinente que pour les langues. Le troisième enjeu de cet essai est de montrer que les formes culturelles et les puissances interprétatives de l’humanité évoluent avec ses machines d’écriture. L’émergence du numérique, en particulier, laisse entrevoir un raffinement des sciences humaines allant jusqu’au calcul de la complexité sémantique. Cet essai de redéfinition des sciences humaines dans la continuité des sciences de la nature suppose une ontologie – ou une méta-ontologie, selon l’expression de Marcello Vitali-Rosati – pour qui les notions d’écriture et de mémoire sont centrales et qui, en rupture avec la critique kantienne, accepte la pleine réalité de la spatialité et de la temporalité naturelle.

Le rôle des humanités numériques dans le nouvel espace politique dans la revue Sens Public, 2019

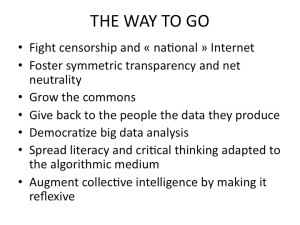

RESUMÉ. Alors que plus de 50% de la population mondiale est connectée à l’Internet, les grandes plateformes, et particulièrement Facebook, ont acquis un énorme pouvoir politique. Cette nouvelle situation nous oblige a repenser le projet d’émancipation des lumières. Je propose dans cet article que les chercheurs en sciences humaines et sociales relèvent ce défi en adoptant et en diffusant de nouvelles normes d’intelligence collective réflexive. Les communs de la connaissance, la science ouverte et la souveraineté des individus sur les données qu’ils produisent font l’unanimité. Mais ces principes incontournables sont encore insuffisants. La puissance de calcul et de communication disponible, combinée à l’utilisation d’IEML (une langue à la sémantique calculable), nous permettent d’envisager une mise en transparence des opérations de création de connaissance, de sens et d’autorité. Je présente ici les grandes orientations stratégiques permettant d’atteindre ces objectifs. Une révolution épistémologique des sciences humaines est à portée de main, et avec elle une nouvelle étape dans l’évolution de la pensée critique. (une cinquantaine de pages)

La Pyramide algorithmique dans la revue Sens Public 2017

RESUMÉ. Le medium algorithmique est une infrastructure de communication qui augmente les pouvoirs des médias antérieurs en y ajoutant la mécanisation des opérations symboliques. Son émergence au milieu du vingtième siècle résulte d’une longue histoire scientifique et technique que je résume au début de l’article. Je rappelle ensuite les grandes étapes de son développement (ordinateurs centraux, internet et PC, Web social, Cloud augmenté par l’intelligence artificielle et la chaîne de blocs) ainsi que leurs conséquences sociocognitives. J’évoque pour finir les développements futurs de ce médium dans la perspective d’une intelligence collective réflexive basée sur une nouvelle forme de calcul sémantique.

Les opérateurs élémentaires de la réflexion, Cahiers Sens public, 2018/1 (n° 21-22), p. 75-102. La philosophie qui a inspiré les “primitives” d’IEML.

RÉSUMÉ. Cet article tente de réduire au minimum les concepts fondamentaux nécessaires à la réflexion sur le sens. Deux concepts complémentaires, la virtualité et l’actualité, rendent compte des dualités de l’action et de la grande opposition métaphysique entre transcendance et immanence. L’actuel possède une adresse spatio-temporelle, il est situé dans le temps séquentiel et dans l’espace physique tridimensionnel tandis qu’on ne peut assigner d’adresse spatio-temporelle précise à l’abstraction du virtuel. Le triangle sémiotique rend compte des triades de la représentation. Le signe (1) indique (2) une chose, un objet ou un référent quelconque auprès (3) d’un être ou interprétant. Il n’y a de signe que « de » quelque chose et « pour » quelqu’un. Enfin, il faut pouvoir considérer explicitement une absence, y compris un vide de connaissance, pour poser des questions et réfléchir. Les six opérateurs élémentaires de la réflexion (virtuel, actuel, signe, être, chose et vide) fonctionnent de manière interdépendante et traversent tous les champs des sciences humaines et sociale : on étudie particulièrement dans cet article leur pertinence en sémiotique, épistémologie, cosmologie, religion, politique et économie.